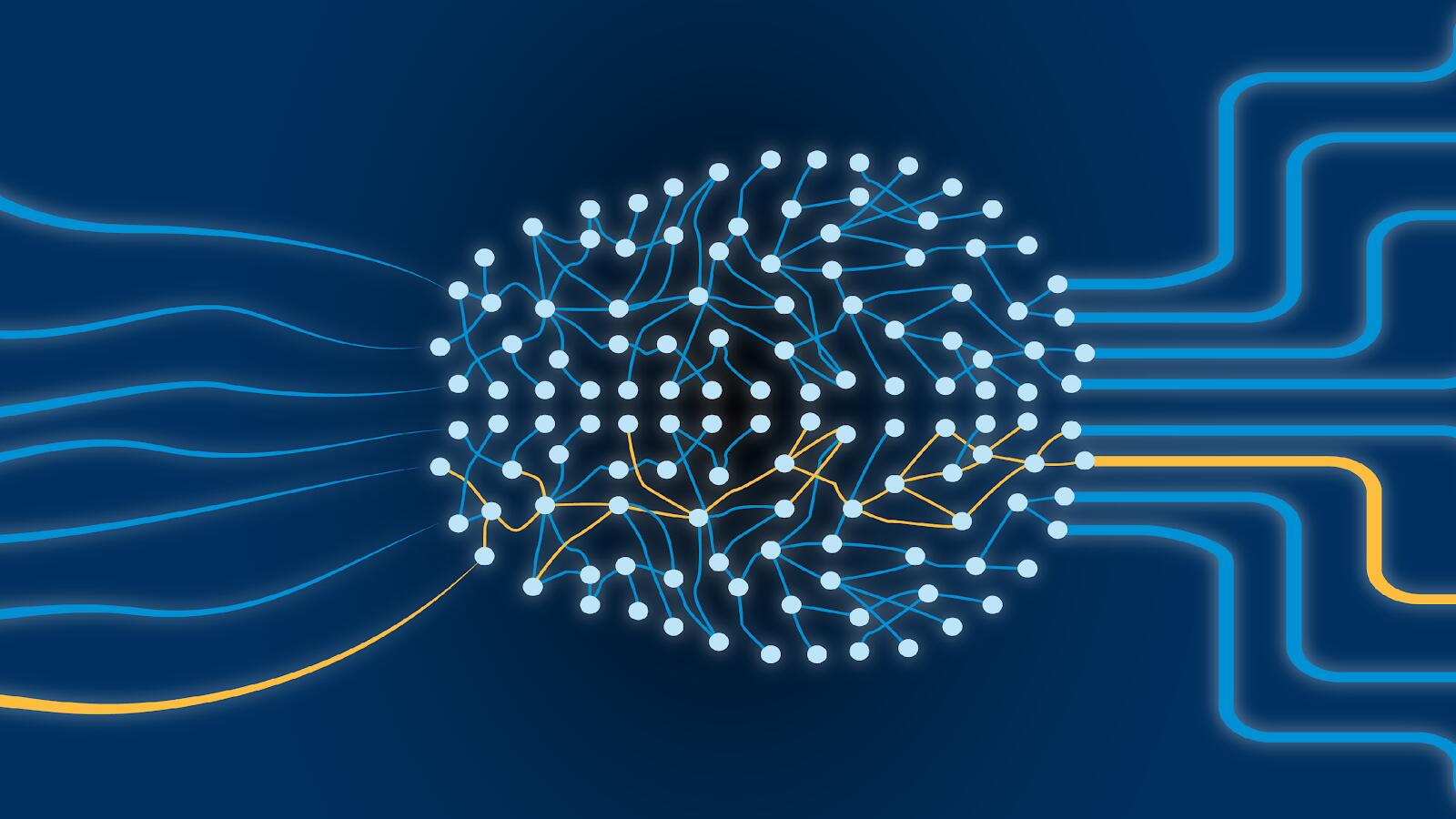

인공지능의 뇌, RNN은 어떻게 세상을 이해할까?

스마트폰에 “내일 날씨 알려줘”라고 말하면 곧바로 답을 들을 수 있고, 유튜브는 나도 모르게 취향에 꼭 맞는 영상을 추천해줍니다. 번역기는 낯선 언어를 이해하게 하고, AI가 작곡한 음악을 감상할 수도 있죠. 이 모든 것은 인공지능의 한 분야인 순환 신경망(RNN, Recurrent Neural Network) 기술 덕분입니다.

RNN은 단순한 기술을 넘어, 우리가 매일 경험하는 서비스의 기반을 이루고 있습니다. 이번 글에서는 RNN이 무엇인지, 어떻게 동작하는지, 그리고 어떤 분야에서 활약하고 있는지를 알아보겠습니다.

순환 신경망이란?

우리 뇌는 과거의 경험을 기억하고, 이를 토대로 새로운 상황에 적응합니다. 예를 들어, “사과는 빨갛다”라는 말을 들으면 ‘사과’라는 단어를 떠올리고, ‘빨갛다’라는 의미를 이해하죠.

RNN은 이처럼 과거 정보를 기억하고 새로운 데이터를 이해하는 능력을 가진 인공지능 모델입니다.

일반 신경망은 입력을 한 번 보고 결과를 내지만, RNN은 데이터의 순서와 시간 흐름을 고려해 처리합니다.

예를 들어:

- 일반 신경망: “사과는 빨갛다”를 각 단어별로 따로 이해

- RNN: “사과 → 사과는 → 사과는 빨갛다”처럼 앞에서부터 문맥을 이해하며 처리

마치 드라마 줄거리를 기억하고 다음 이야기를 예측하는 것처럼, RNN은 과거 정보를 기반으로 데이터를 이해하고 예측합니다.

RNN의 다양한 활용 분야와 구체적인 사례

RNN는 데이터의 순서와 시간 흐름을 이해해야 하는 분야에서 강점을 보입니다.

자연어 처리(NLP)

- 스마트폰의 음성 비서(시리, 알렉사)는 사용자의 말을 순서대로 이해하고, 의도에 맞는 답을 제공합니다.

- 번역기(예: Google Translate)는 문장의 흐름을 파악해 자연스러운 번역을 생성합니다.

- 감정 분석과 챗봇도 문맥을 이해해 대화의 자연스러움을 높입니다.

- 초기 대화형 AI(예: seq2seq 기반의 encoder-decoder 모델)에서는 RNN이 문장 흐름을 이해하고 답변을 생성하는 데 사용되었습니다.

추천 시스템

- TikTok과 넷플릭스 등은 초기 추천 시스템에서 사용자의 시청 데이터를 RNN으로 학습하여 시퀀스 데이터를 기반으로 추천을 제공했습니다.

- 예를 들어, TikTok은 사용자가 본 영상 순서, 시청 시간, 스킵한 영상을 분석해 취향에 맞는 콘텐츠를 추천하는 데 RNN을 활용했습니다. 최근에는 Transformer 기반 모델이 등장했지만, 초기 시퀀스 데이터 분석에서 RNN이 중요한 역할을 했습니다.

음악과 예술

- AI는 기존 음악의 패턴을 학습해 새로운 멜로디를 만들어냅니다.

- 유튜브의 자동 자막 기능은 RNN을 활용해 영상 속 음성을 실시간으로 분석하고 자막을 생성합니다.

시계열 데이터 분석

- 스마트워치는 심박수 데이터를 연속 측정해 건강 상태를 예측합니다.

- 주식 시장의 데이터를 분석해 미래 가격을 예측하거나, 기후 예측처럼 시간에 따라 변화하는 데이터를 처리합니다.

실시간 처리

- 챗봇과 음성 명령 인식 시스템은 데이터를 즉각적으로 처리해 응답을 제공합니다.

- RNN은 순차적 데이터 이해와 빠른 처리 속도로 이러한 분야에서 핵심적인 역할을 합니다.

RNN의 작동 원리

RNN은 입력층(데이터를 받는 곳), 은닉층(과거 정보 저장), 출력층(결과 생성)으로 구성됩니다.

은닉층에서는 이전 상태를 현재 입력과 결합해 새로운 상태를 만들어냅니다.

계산식으로는 다음과 같이 표현됩니다:

hₜ=tanh 𝑊ₕₕ∗hₜ−1+𝑊ₓₕ∗𝑥ₜ+𝑏ₕ

즉, 과거 상태(hₜ−1

)와 현재 입력(𝑥𝑡

)을 더해 새로운 상태(h𝑡

)를 만들어내는 과정이 반복됩니다.

RNN은 기억을 가진 계산기처럼 데이터를 처리하는 셈입니다.

RNN의 한계와 도전

RNN은 뛰어난 기술이지만, 한계도 분명합니다.

- 장기 의존성 문제: 긴 문장에서 처음 정보를 끝까지 기억하기 어려운 문제가 있습니다.

- 기울기 소실/폭발: 학습 도중 오류 신호가 너무 작아지거나 커져 학습이 불안정해질 수 있습니다.

- 순차적 처리의 한계: 데이터를 한 단계씩 처리하기 때문에 속도가 느리고 대규모 데이터 처리에는 한계가 있습니다.

- 복잡한 데이터 처리의 한계: 시퀀스 데이터는 잘 처리하지만, 그래프나 복잡한 관계 데이터를 이해하는 데는 약점을 보입니다.

이 때문에 연구자들은 RNN의 한계를 극복하기 위해 발전형 모델과 새로운 접근법을 개발했습니다.

발전형 모델과 Transformer의 등장

RNN의 한계를 보완하기 위해 LSTM(Long Short-Term Memory)와 GRU(Gated Recurrent Unit)가 개발되었습니다.

LSTM은 중요 정보는 오래 유지하고 불필요한 정보는 잊게 설계되어 장기 의존성 문제를 해결했습니다. GRU는 비슷한 기능을 가지면서 더 단순한 구조로 빠른 학습을 가능하게 했습니다.

그리고 한 단계 더 나아가, Transformer가 등장했습니다. Transformer는 RNN과 달리 Self-Attention 메커니즘을 도입해 입력 전체를 동시에 바라보고 단어 간 관계를 계산합니다.

즉, 데이터를 순차적으로 처리하지 않아도 되고, 병렬 처리도 가능해 긴 문장과 대규모 데이터를 빠르고 정확하게 처리할 수 있습니다. Google 번역기, BERT, GPT 등 최신 자연어 처리 모델들이 모두 Transformer 기반입니다.

| 항목 | RNN/LSTM/GRU | Transformer |

| 처리 방식 | 순차적 처리 | Self-Attention으로 전체 입력 동시 처리 |

| 병렬 처리 | 불가능 | 가능 |

| 장기 의존성 문제 | 존재(LSTM/GRU로 개선) | 거의 없음 |

| 속도 | 느림 | 빠름 |

| 복잡한 데이터 처리 | 시퀀스에 강점, 관계 처리 어려움 | 문서, 그래프 등 다양한 관계 처리 가능 |

| 활용 | 음성인식, 시계열 분석 등 | 번역, 텍스트 생성, 챗봇 등 |

RNN의 미래와 발전 가능성

Transformer의 등장으로 RNN의 주목도는 줄었지만, 시계열 데이터(기후 예측, 금융 데이터, 센서 데이터)와 실시간 처리(음성 명령 인식 등) 분야에서는 여전히 강력한 역할을 합니다.

앞으로는 RNN과 Transformer의 장점을 결합한 하이브리드 모델, Graph Neural Network(GNN), TS-GNN(시간-공간 네트워크) 등 최신 기술과의 융합이 활발히 진행될 것입니다.

즉, RNN은 단순히 과거의 기술이 아니라, 인공지능 발전의 초석이자 새로운 기술의 기반입니다.

마무리

다음에 스마트폰 음성 비서를 사용할 때, 유튜브 추천 영상을 볼 때, 혹은 AI가 작곡한 음악을 들을 때, 그 뒤에 RNN이 있다는 사실을 떠올려보세요.

RNN은 과거를 기억하고 미래를 예측하는 능력으로 우리의 삶을 더 편리하고 흥미롭게 만들어주고 있습니다.